获取数据

requests库

获取数据环节需要用到requests库。安装方式也简单

pip install requests

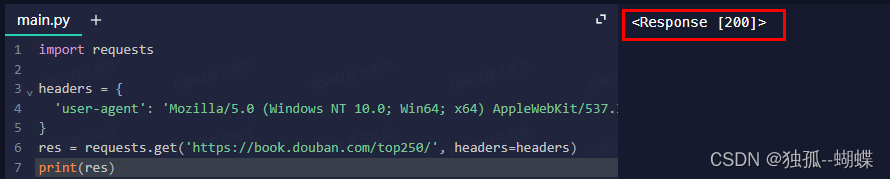

爬取页面豆瓣读书 Top 250

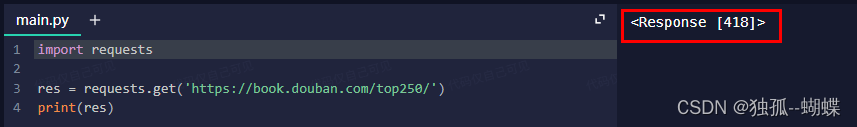

用requests库来访问

python">import requests

res = requests.get('https://book.douban.com/top250/')解析:

- 导入requests库

- 调用了requests库中的get() 方法,传入URL 发送请求,并把收到的响应保存到变量res中

res长什么样呢?我们打印一下

变量res的值是<Response [418]>,怎么回事呢?

Response对象

这是因为,HTTP 响应内容不单单包括客户端所请求的资源本身,还包含响应状态等信息。因此 requests 库选择将获取的响应打包为 Response 对象,方便我们通过类的 属性 或 方法 获取想要的内容。而当我们打印 Response 对象本身时,Python 会按照 requests 库约定好的方式,打印出类名(Response)和本次响应状态码。

<Response [418]>,说明本次响应状态为418,表明本次请求发生了客户端错误

消息头 headers

按照下面的步骤操作一下

- 点击练习上面的 URL,此时浏览器会在新标签页为你打开豆瓣读书 Top 250 页面;

- 页面加载完成后,打开网页开发者工具,切换到 Network 面板;

- 刷新页面;

- 在 Network 面板请求列表中找到名为 top250 的请求,并在请求详情页找到 Request Headers(请求头) 信息。

无论是浏览器想服务器发送请求,还是服务器想浏览器作出响应,这中间都会通过header传递附加信息。这些附加信息中就包含了我们爬虫程序伪装浏览器的关键。

观察请求列表中每条请求的消息头,我们会发现许多重复出现的名称,其中有一项名为 user-agent。(下面这个是我电脑上的,每个人的应该都有差异)

User-Agent:

Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36

我们只需要将需要附上的信息组织成 字典 的格式,再通过 headers 参数传递给 get() 方法,requests 库帮我们向服务器发送请求时,就会自动带上这些信息了。

python">import requests

# 定制消息头

headers = {

# 消息头中有一项附加信息 user-agent

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36'

}

# 携带消息头向服务器发送请求

res = requests.get('https://book.douban.com/top250/', headers=headers)伪装成功了!

requests 库早已把响应内容转换为 字符串 类型,保存到 Response 对象的 text 属性中,我们能很轻松地通过 . 运算符访问到:

python">import requests

headers = {

'user-agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/99.0.4844.51 Safari/537.36'

}

res = requests.get('https://book.douban.com/top250/', headers=headers)

print(res.text)

# 输出:

# <!DOCTYPE html>

# <html lang="zh-cmn-Hans" class="ua-mac ua-webkit book-new-nav">

# <head>

# <meta http-equiv="Content-Type" content="text/html; charset=utf-8">

# <title>豆瓣读书 Top 250</title>

# ...返回的是HTML源代码。

解析数据

BeautifulSoup对象

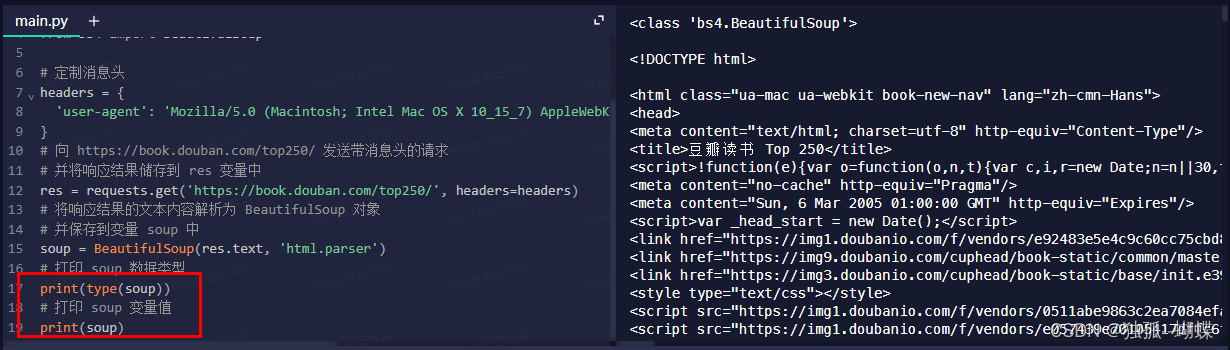

解析数据我们需要用到BeautifulSoup对象。

安装

pip install bs4

导入

from bs4 import BeautifulSoup

说明文档主要说明两个关键信息:

- 创建 BeautifulSoup 对象 时,它会把 HTML/XML 文档解析成 树形结构

- BeautifulSoup 类继承自 Tag 类,因此 BeautifulSoup 类和 Tag 类有许多共用的方法。

创建

创建BeautifulSoup对象时,需要传入两个参数:

- 所需解析的 HTML 代码,即响应的文本内容(

res.text); - 用于解析 HTML 代码的 解析器,课程内使用的是 Python 内置解析器

html.parser(parser:解析器)。

python"># 导入 requests 库

import requests

# 从 bs4 库中导入 BeautifulSoup

from bs4 import BeautifulSoup

# 定制消息头

headers = {

'user-agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/99.0.4844.51 Safari/537.36'

}

# 发送带消息头的请求

res = requests.get('https://book.douban.com/top250', headers=headers)

# 创建 BeautifulSoup 对象,解析响应的文本内容

soup = BeautifulSoup(res.text, 'html.parser')执行结果

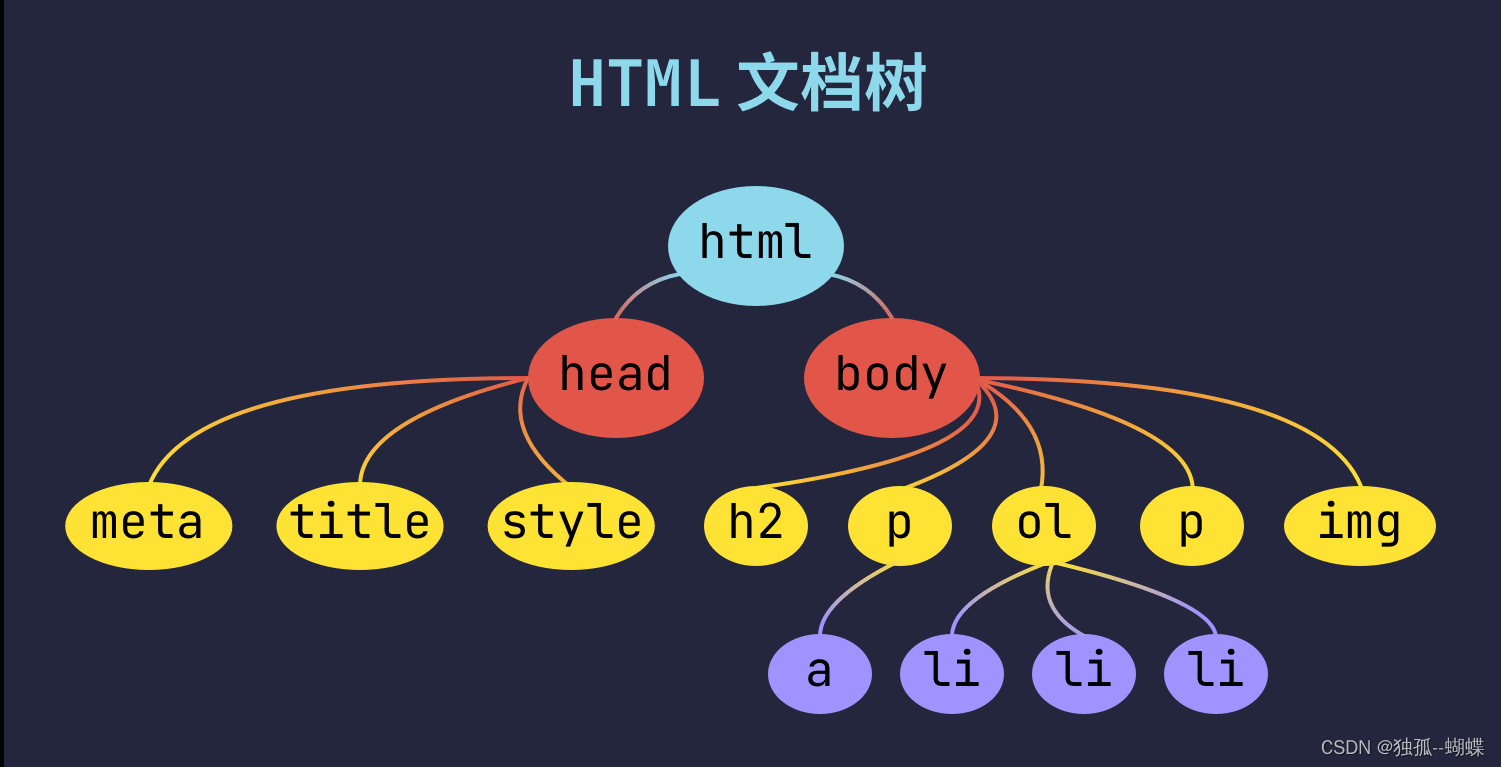

BeautifulSoup 对象 内部结构像一棵倒着生长的树,树根在上面,枝叶在下面,每个节点都对应着 HTML 代码中的一个元素。顺着这棵 HTML 文档树,我们就能定位到某个或某群具有相同特征的元素,从而提取出元素文本内容——也就是我们所需的数据。

HTML 文档树

<!DOCTYPE html>

<html lang="zh">

<head>

<meta charset="UTF-8">

<title>我的网页</title>

<style> body { background-color: #101324; color: #ffffff; font-family: -apple-system, BlinkMacSystemFont, 'Segoe UI', Roboto, 'Helvetica Neue', Arial, 'Noto Sans', sans-serif, 'Apple Color Emoji', 'Segoe UI Emoji', 'Segoe UI Symbol', 'Noto Color Emoji'; } a { color: #1890ff; } code { background: rgba(255, 255, 255, 0.15); padding: 0 6px; border-radius: 4px; color: rgba(255, 255, 255, 0.87); } img { width: 100%; } </style>

</head>

<body>

<h2>Web 真好玩!</h2>

<p>今天我在 <a href="https://web.shanbay.com/codetime-study/pc/uduni">爬虫课第 2 关</a> 学到了这些内容:</p>

<ol>

<li>HTML 基本语法</li>

<li>HTML 文档结构</li>

<li>Elements 面板 <code>Edit text</code> 功能</li>

</ol>

<p>其中常见的 HTML 元素有这些:</p>

<img src="https://media-image1.baydn.com/storage_media_image/svpyor/ff5185b0ab456965c9f89c7506ed0a9e.bff6930d34f5dca7819b5e571f421b9b.png">

</body>

</html>该 HTML 文档根节点为 html 元素。它有两个子节点,分别是 head 元素 和 body 元素。再往内推,head 与 body 内也分别包含诸多元素。我们将这些元素按照 根节点 – 子节点 – 子节点的子节点…… 顺序从上至下梳理出的图谱,就是 HTML 文档树。

一棵文档树就像是这些元素的族谱:

- html 元素是所有其它元素的 祖先,反过来说,其它元素都是 html 的 后代;

- head 元素和 body 元素的 父节点 是 html 元素,因此它们是 html 的 直接后代;

- 由于 head 和 body 父节点相同,所以它们互为 兄弟节点;

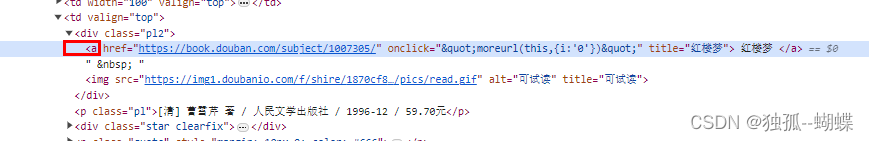

提取数据

通过css选择器提取

CSS 选择器

CSS 选择器是 CSS 语言中的一部分,能通过 HTML 元素的 类型、标识 和 关系 快速选择符合条件的 所有元素。

靠 class 属性值检索的选择器被称为 类选择器,需要写成 .class_name,表示检索所有 class 属性值为 class_name 的元素。靠 id 属性值检索的被称为 ID 选择器,写成 #id_name,表示检索所有 id 属性值为 id_name 的元素。

元素与元素之间的关系可以分为 祖先 – 后代、祖先 – 直接后代、兄弟 – 兄弟 三类,因此两个元素之间的组合关系也分为三种:

A B:检索 A 元素 后代 中的所有 B 类型元素;A > B:检索 A 元素 直接后代 中所有 B 类型元素;A ~ B:检索 A 元素 兄弟 中所有 B 类型元素。

总结一下,选择器分为两大类:

- 基本选择器:通过元素的 类型、class 属性值、id 属性值 检索;

- 组合选择器:通过元素和元素之间的 关系 检索,分为 直接后代组合器、后代组合器 和 兄弟组合器。

我们需要从豆瓣读书 Top 250 页面中提取出每本书的 书名、作者 和 出版社 信息。通过检查元素我们发现,每本书的结构是一致的,并且书名信息都在 a 元素之中:

根据上面学习的方法,什么样的css选择器可以定位到书名信息所在的a元素呢?

div.pl2 > a 和 div.pl2 a 均可。

select() 方法

BeautifulSoup 对象 有一个名为 select() 的方法,我们将 CSS 选择器 传进去,它会返回一个列表,列表中每个元素都是符合条件的检索结果。

python"># 前面代码省略,soup 为解析好的 BeautifulSoup 对象

book_name_tags = soup.select('div.pl2 a')

print(book_name_tags)

# 输出:

# [<a href="https://book.douban.com/subject/1007305/" onclick=""moreurl(this,{i:'0'})"" title="红楼梦">

# 红楼梦

# </a>, <a href="https://book.douban.com/subject/4913064/" onclick=""moreurl(this,{i:'1'})"" title="活着">

# 活着

# </a>, <a href="https://book.douban.com/subject/6082808/" onclick=""moreurl(this,{i:'2'})"" title="百年孤独">

# 百年孤独

# </a>, ...]

print(type(book_name_tags[0]))

# 输出:<class 'bs4.element.Tag'>可以看到,所有书名信息所在元素都被我们提取出来了。并且通过打印 book_name_tags 列表第一个元素的数据类型我们发现,它是一个特殊的数据类型,Tag 类。正如我在介绍 BeautifulSoup 对象时说过的,BeautifulSoup 类继承自 Tag 类。我们通过 select() 方法获得的一个个节点,是一个个 Tag 对象。

Tag对象

Tag 类有许多实用的属性和方法,最为常用的是以下三个

- tag.text 获取标签的文本内容

- tag['属性名'] 获取标签 HTML 属性的值

- tag.select() 方法 返回被选择器选助攻的所有元素

是的,Tag 类也有 select() 方法——这是因为,BeautifulSoup 类中的 select() 方法就是继承自 Tag 类的。除此之外,我们还能通过 Tag 对象的 text 属性访问到该元素的 元素内容,通过 Tag对象['元素属性名称'] 形式访问到该元素的某个属性的值。

比如对于 book_name_tags 列表中第一个元素来说

python">book = book_name_tags[0]

print(book)

# 输出:

# <a href="https://book.douban.com/subject/1007305/" onclick=""moreurl(this,{i:'0'})"" title="红楼梦">

# 红楼梦

# </a>我们可以通过 book.text 获取元素内容,通过 book['href'] 获取图书链接。

python">print(book['title'])

# 输出:红楼梦同样的道理,我们可以编写代码提取出每本书作者、出版社信息所在元素

python"># 前面代码省略,soup 为解析好的 BeautifulSoup 对象

book_info_tags = soup.select('p.pl')

print(book_info_tags)

# 输出:

# [<p class="pl">[清] 曹雪芹 著 / 人民文学出版社 / 1996-12 / 59.70元</p>, <p class="pl">余华 / 作家出版社 / 2012-8-1 / 20.00元</p>, <p class="pl">[哥伦比亚] 加西亚·马尔克斯 / 范晔 / 南海出版公司 / 2011-6 / 39.50元</p>, ...]

可以看到,书籍信息存在于 p 元素的 文本内容 中,我们可以通过 text 属性获取。每条书籍信息则由若干项组成,依次是作者、译者(如果为外文作品)、出版社、出版年份、图书价格,每项中间用 / 分割。因此我们在提取图书作者、出版社信息时可分以下四步:

- 遍历

book_info_tags中每个元素; - 对每个元素,通过

text属性获取书籍信息,保存到info里; - 按

/分割info字符串,得到列表info_list; info_list中 第一项元素 是作者信息,倒数第三项元素 是出版社信息。

python"># 前面代码省略,soup 为解析好的 BeautifulSoup 对象

book_info_tags = soup.select('p.pl')

# 遍历所有书籍信息元素

for info_tag in book_info_tags:

# 获取书籍信息

info = info_tag.text

# 按“ / ”分割字符串

info_list = info.split(' / ')

# 结果列表中第一项为作者信息

author = info_list[0]

# 倒数第三项为出版社信息

publisher = info_list[-3]

print(author, publisher)

# 输出:

# [清] 曹雪芹 著 人民文学出版社

# 余华 作家出版社

# [哥伦比亚] 加西亚·马尔克斯 南海出版公司

# ...下面是整体代码

python"># 导入 requests 库

import requests

# 从 bs4 库导入 BeautifulSoup

from bs4 import BeautifulSoup

# 定制消息头

headers = {

'user-agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/99.0.4844.51 Safari/537.36'

}

# 向 https://book.douban.com/top250/ 发送带消息头的请求

# 并将响应结果储存到 res 变量中

res = requests.get("https://book.douban.com/top250/", headers=headers)

# 将响应结果的文本内容解析为 BeautifulSoup 对象

# 并保存到变量 soup 中

soup = BeautifulSoup(res.text, 'html.parser')

# 所有书名所在元素

book_name_tags = soup.select('div.pl2 a')

# 所有书籍信息所在元素

book_info_tags = soup.select('p.pl')

print(book_info_tags)

# 遍历每本图书

for i in range(len(book_name_tags)):

# 通过元素 title 属性提取书名

name = book_name_tags[i]['title']

# 获取书籍信息

info = book_info_tags[i].text

# 按“ / ”分割字符串

info_list = info.split("/")

# 结果列表中第一项为作者信息

author = info_list[0]

# 倒数第三项为出版社信息

publisher = info_list[-3]

# 打印书名、作者、出版社信息

print(name, author, publisher)下面是返回的结果

[<p class="pl">[清] 曹雪芹 著 / 人民文学出版社 / 1996-12 / 59.70元</p>, <p class="pl">余华 / 作家出版社 / 2012-8 / 20.00元</p>, <p class="pl">[英] 乔治·奥威尔 / 刘绍铭 / 北京十月文艺出版社 / 2010-4-1 / 28.00</p>, <p class="pl">J.K.罗琳 (J.K.Rowling) / 苏农 / 人民文学出版社 / 2008-12-1 / 498.00元</p>, <p class="pl">刘慈欣 / 重庆出版社 / 2012-1 / 168.00元</p>, <p class="pl">[哥伦比亚] 加西亚·马尔克斯 / 范晔 / 南海出版公司 / 2011-6 / 39.50元</p>, <p class="pl">[美国] 玛格丽特·米切尔 / 李美华 / 译林出版社 / 2000-9 / 40.00元</p>, <p class="pl">[英] 乔治·奥威尔 / 荣如德 / 上海译文出版社 / 2007-3 / 10.00元</p>, <p class="pl">林奕含 / 北京联合出版公司 / 2018-2 / 45.00元</p>, <p class="pl">[明] 罗贯中 / 人民文学出版社 / 1998-05 / 39.50元</p>, <p class="pl">[英] 阿·柯南道尔 / 丁钟华 等 / 群众出版社 / 1981-8 / 53.00元/68.00元</p>, <p class="pl">[日] 东野圭吾 / 刘姿君 / 南海出版公司 / 2013-1-1 / 39.50元</p>, <p class="pl">[法] 圣埃克苏佩里 / 马振骋 / 人民文学出版社 / 2003-8 / 22.00元</p>, <p class="pl">(丹麦)安徒生 / 叶君健 / 人民文学出版社 / 1997-08 / 25.00元</p>, <p class="pl">金庸 / 生活·读书·新知三联书店 / 1994-5 / 96.00元</p>, <p class="pl">三毛 / 哈尔滨出版社 / 2003-8 / 15.80元</p>, <p class="pl">鲁迅 / 人民文学出版社 / 1973-3 / 0.36元</p>, <p class="pl">【美】傅高义 (Ezra.F.Vogel) / 冯克利 / 生活·读书·新知三联书店 / 2013-1-18 / 88.00元</p>, <p class="pl">[德] 赫尔曼·黑塞 / 姜乙 / 天津人民出版社 / 2017-1 / 32.00元</p>, <p class="pl">[美] 哈珀·李 / 高红梅 / 译林出版社 / 2012-9 / 32.00元</p>, <p class="pl">当年明月 / 中国海关出版社 / 2009-4 / 358.20元</p>, <p class="pl">[意] 埃莱娜·费兰特 / 陈英 / 人民文学出版社 / 2018-7 / 62.00元</p>, <p class="pl">[意] 埃莱娜·费兰特 / 陈英 / 人民文学出版社 / 2017-4 / 59.00元</p>, <p class="pl">鲁迅 / 人民文学出版社 / 1973-3 / 0.20元</p>, <p class="pl">王小波 / 中国青年出版社 / 1997-10 / 27.00元</p>]

红楼梦 [清] 曹雪芹 著 人民文学出版社

活着 余华 作家出版社

1984 [英] 乔治·奥威尔 北京十月文艺出版社

哈利·波特 J.K.罗琳 (J.K.Rowling) 人民文学出版社

三体全集 刘慈欣 重庆出版社

百年孤独 [哥伦比亚] 加西亚·马尔克斯 南海出版公司

飘 [美国] 玛格丽特·米切尔 译林出版社

动物农场 [英] 乔治·奥威尔 上海译文出版社

房思琪的初恋乐园 林奕含 北京联合出版公司

三国演义(全二册) [明] 罗贯中 人民文学出版社

福尔摩斯探案全集(上中下) [英] 阿·柯南道尔 1981-8

白夜行 [日] 东野圭吾 南海出版公司

小王子 [法] 圣埃克苏佩里 人民文学出版社

安徒生童话故事集 (丹麦)安徒生 人民文学出版社

天龙八部 金庸 生活·读书·新知三联书店

撒哈拉的故事 三毛 哈尔滨出版社

呐喊 鲁迅 人民文学出版社

邓小平时代 【美】傅高义 (Ezra.F.Vogel) 生活·读书·新知三联书店

悉达多 [德] 赫尔曼·黑塞 天津人民出版社

杀死一只知更鸟 [美] 哈珀·李 译林出版社

明朝那些事儿(1-9) 当年明月 中国海关出版社

失踪的孩子 [意] 埃莱娜·费兰特 人民文学出版社

新名字的故事 [意] 埃莱娜·费兰特 人民文学出版社

野草 鲁迅 人民文学出版社

沉默的大多数 王小波 中国青年出版社